您现在的位置是:首页 >综合 > 2021-05-06 22:09:32 来源:

Nvidia推出大量AI处理芯片Tesla V100

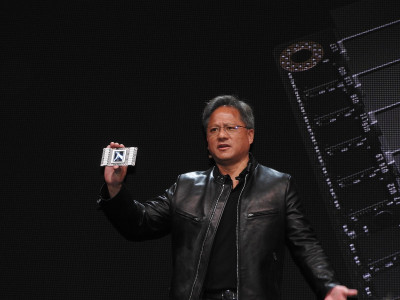

Nvidia首席执行官Jen-Hsun Huang为人工智能应用推出了一款雄心勃勃的全新处理器Tesla V100。

这款新芯片拥有210亿个晶体管,比一年前Nvidia宣布的150亿个基于Pascal的处理器强大了一个数量级。这是一块巨大的芯片 - 815平方毫米,或者像Apple Watch那样大。它有5,120个CUDA处理内核,并且在7.5 FP64 teraflops下运行。性能大约是去年产品的三倍。

总部位于加利福尼亚州圣克拉拉的Nvidia是最大的图形和AI芯片制造商,它在加利福尼亚州圣何塞举行的GPU技术大会上宣布了这一消息。

了解开发商和品牌营销人员如何利用人工智能发展他们的业务,将于7月11日至12日在SF的MB中展示。我们通过大肆宣传来展示营销人员如何实现真正的投资回报率。在5月19日之前享受早鸟优惠 50%%的优惠!

在介绍芯片之前,黄先生追溯了人工智能的近期历史。他指出,深度学习神经网络研究大约在五年前开始取得成效,当时研究人员开始使用图形处理单元(GPU)并行处理数据以快速训练神经网络。从那时起,深度学习的步伐加快了。而今年,Nvidia计划培训100,000名开发人员使用深度学习。

对于深度学习,特斯拉V100,也称为Volta,可以处理120张Tensor teraflops。它可以以每秒300千兆位的速度传输数据,或者比现在的其他处理器快20倍。它由三星为Nvidia制造。

与去年基于Pascal的处理器相比,Volta的Tensor FLOP用于深度学习训练的12倍。由于深度学习算法的惊人进步,这种处理速度是必要的。

2015年,微软创建了一个名为ResNet的深度学习程序,它非常复杂,需要7个exaflops的处理能力。2016年,百度的Deep Speech 2 AI需要20次exaflops,而2017年Google的NMT需要105次exaflops。

微软正在开发一个新版本的ResNet,它将64个Volta芯片连接在一起进行处理。目前还不清楚Volta何时将大量出货。