您现在的位置是:首页 >要闻 > 2020-12-11 11:30:19 来源:

AI代理使用日常语言提供理由以解释其行为

该代理还使用非专家可以理解的日常语言。研究人员称之为解释,或称“理性”,旨在与人们建立联系,并激发他们对可能使用AI机器或在社交场合与他们互动的人的信任。

Upol Ehsan博士说:“如果要使AI的力量民主化,那么任何人都必须能够使用AI,无论他们的技术水平如何。” 乔治亚理工学院互动计算学院的学生,首席研究员。

“随着AI渗透到我们生活的方方面面,对以人为中心的AI设计的独特需求使黑盒AI系统可以为日常用户所解释。我们的工作迈出了形成性的一步,旨在理解基于语言的解释的作用以及如何人类会感知到它们。”

该研究得到海军研究办公室(ONR)的支持。

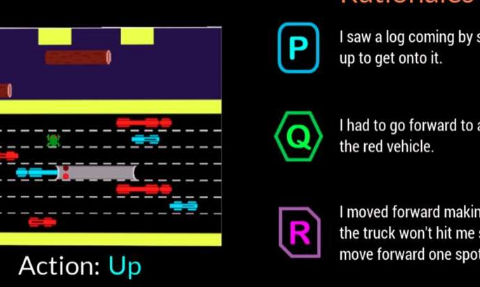

研究人员开展了一项参与研究,以确定他们的AI代理是否可以提供模仿人类反应的理论依据。观众观看了AI代理玩电子游戏Frogger,然后按照每个人对AI的动作描述得如何好坏的顺序排列了三个屏幕上的理由。

在每个动作的三个匿名理由中,一个是人为产生的反应,AI代理反应和一个随机产生的反应,参与者首先喜欢人为产生的理由,而第二个是人工智能产生的反应。

Frogger为研究人员提供了在“顺序决策环境”中训练AI的机会,这是一项重大的研究挑战,因为代理商已经做出的决策会影响未来的决策。因此,根据研究人员的说法,很难向专家解释推理链,甚至在与非专家交流时更是如此。

观众们明白了青蛙蛙的目的,就是使青蛙安全回家,而不会被移动的车辆撞到或淹死在河中。向上,向下,向左或向右移动的简单游戏机制,使参与者可以查看AI所做的事情,并评估屏幕上的基本原理是否明确说明了该移动的合理性。

观众根据以下各项判断其合理性:

信心-人们对AI执行任务充满信心

像人一样-看起来像是由人创造的

充分的理由-充分证明所采取的行动是合理的

可理解性-帮助人们了解AI的行为

参与者排名较高的AI产生的理由是那些表现出对环境条件和适应性的认可,以及传达了对即将发生的危险的意识并为之计划的理由。发现仅表明环境明显或特征错误的冗余信息具有负面影响。