您现在的位置是:首页 >人工智能 > 2021-04-28 08:36:08 来源:

帮助机器人处理不确定性

分散的部分可观察马尔可夫决策过程是一种模拟自主机器人行为的方式,在这种情况下,他们彼此之间的沟通以及他们对外部世界的判断都不是完美的。

Dec-POMDPs(因为它们的缩写)的问题在于它们和它们的名字一样复杂。他们提供了最严格的多智能体系统数学模型 - 不仅仅是机器人,而是任何自治网络设备 - 不确定性。但对于除了最简单的情况之外的所有情况,它们都非常耗费时间来解决。

去年夏天,麻省理工学院的研究人员提交了一篇论文,使得Dec-POMDP对现实世界的机器人系统更加实用。他们表明,Dec-POMDP可以确定将现有的低级机器人控制系统拼接在一起以完成集体任务的最佳方式。通过为Dec-POMDP提供细节,这种方法使得它们在计算上易于处理。

在今年的机器人与自动化国际会议上,麻省理工学院的另一个研究小组将这一方法更进了一步。他们的新系统实际上可以从头开始生成低级控制系统,同时仍能在合理的时间内解决Dec-POMDP模型。

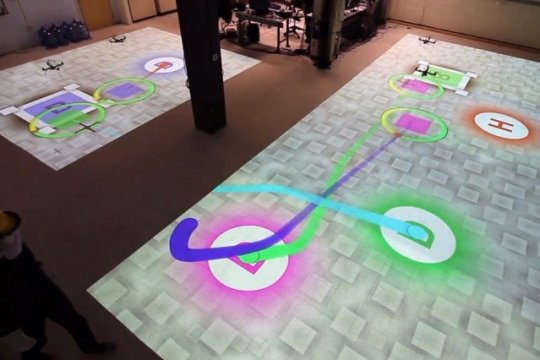

研究人员还在一小组机器人直升机上测试了他们的系统,模拟了亚马逊和谷歌设想的无人机包裹递送类型,但增加的限制是机器人无法相互通信。

“有一个离线计划阶段,代理人可以一起制定一个政策,说:'如果我采取这一系列行动,假设我在网上执行期间做了这些观察,你采取其他一系列行动,鉴于你已经做了这些观察,然后我们都同意我们采取的整套行动非常接近最优,“麻省理工学院航空航天研究生,新论文第一作者Shayegan Omidshafiei说。“在线阶段没有任何意义,代理商停下来说,'这是我的信念。这是你的信念。让我们就最佳整体信念和重新计划达成共识。' 每个人都做自己的事情。“

Dec-POMDP如此复杂的原因在于它们明确地考虑了不确定性。世界上的自主机器人可能依赖于其传感器读数来确定其位置。但是它的传感器可能会略微容易出错,因此任何给定的读数都应该被解释为定义围绕实际测量的概率分布。

然而,即使是精确的测量也可以解释,因此机器人需要在传感器读数的概率分布之上建立可能位置的概率分布。然后它必须选择一个行动方案,但其可能的行动将有自己的成功概率。如果机器人参与协作任务,它还必须考虑其他机器人的可能位置及其随后采取特定行动的可能性。

由于概率分布由一系列可能的值组成 - 原则上是无穷多的值 - 解决概率上的概率问题要比解决涉及离散值的问题困难得多。

为了更容易解决Dec-POMDP,Omidshafiei和他的合着者 - 他的论文顾问,Maclaurin航空航天教授Jonathan How; Ali-akbar Agha-mohammadi,麻省理工学院信息与决策系统实验室前博士后现任高通研究所; 克里斯托弗·阿马托(Christopher Amato)曾在麻省理工学院计算机科学与人工智能实验室担任博士后12月POMDP的早期工作,并刚刚加入新罕布什尔大学的教职员工 - 将其分解为两个问题,两个问题都涉及到图表。

图表是由节点组成的数据表示,通常描绘为圆圈和边缘,通常描绘为连接圆圈的线条。网络图和家谱是熟悉的例子。

研究人员的算法首先构建一个图表,其中每个节点代表一个“信念状态”,意味着代理人自己的状态和世界状态的概率估计。然后,算法创建一组控制程序 - 图形的边缘 - 可以在信念状态之间移动代理。

研究人员将这些控制程序称为“宏观行动”。因为单个宏动作可以在其起源和目的地处容纳一系列信念状态,所以规划算法在将其传递到下一阶段之前已经消除了一些问题的复杂性。

对于每个代理,该算法然后构造第二图,其中节点表示在前一步骤中定义的宏动作,并且边根据观察结果表示宏动作之间的转换。在新论文中报告的实验中,研究人员随后对代理人打算执行的任务进行了大量模拟,代理人在每次运行开始时采用不同的随机状态。基于代理每次执行其任务的程度,规划算法为图的节点处的宏动作和节点之间的转换分配不同的权重。

结果是一个图表,捕捉了一个代理人应该执行特定宏观行动的概率,既考虑了过去的行为,又考虑了周围世界的观察。虽然这些概率基于模拟,但原则上,自治代理可以通过对其环境的物理探索来构建相同类型的图。

最后,算法选择具有最高权重的宏动作和转换。这产生了各个代理可以遵循的确定性计划:执行宏操作A后,如果进行测量B,则执行宏操作C.